Como o Feedback Humano Está Revolucionando o Treinamento de Inteligências Artificiais

Pesquisadores desenvolvem método inovador que usa avaliações humanas para aprimorar sistemas de IA. Técnica promete tornar as máquinas mais seguras, éticas e alinhadas com valores humanos.

O Novo Horizonte da Aprendizagem de Máquinas

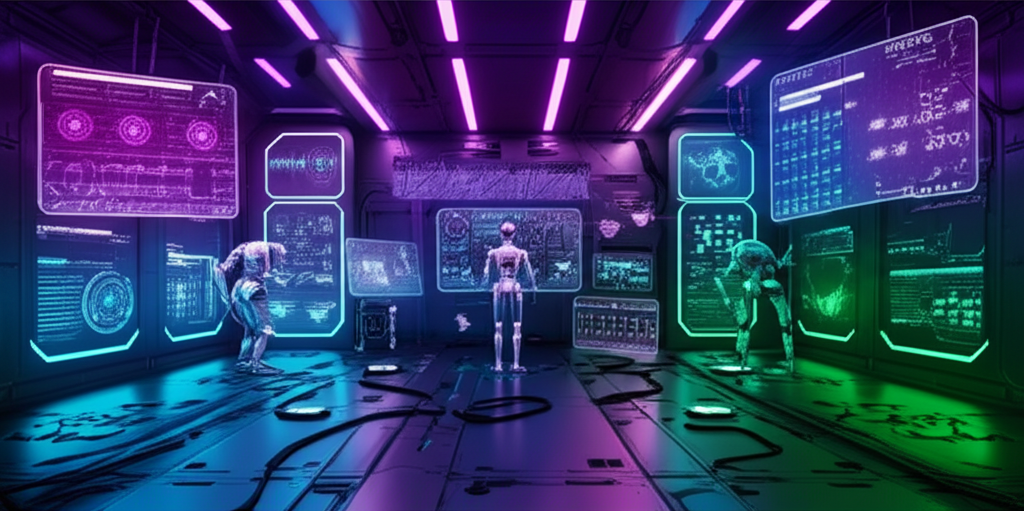

Um avanço significativo no campo da inteligência artificial está transformando a forma como os sistemas aprendem com os humanos. Pesquisadores desenvolveram uma metodologia chamada Aprendizado por Reforço com Feedback Humano (RLHF na sigla em inglês), que promete resolver um dos maiores desafios da IA contemporânea: como garantir que sistemas complexos se mantenham alinhados com os valores e necessidades humanas.

O Problema dos Sistemas Autônomos

Conforme as inteligências artificiais se tornam mais sofisticadas, os métodos tradicionais de treinamento mostram limitações. 'Quando deixamos as máquinas aprenderem apenas com dados brutos, sem orientação humana, podemos ter resultados imprevisíveis ou até perigosos', explica a pesquisa. O RLHF surge como uma ponte entre a capacidade computacional das IAs e a sabedoria humana.

Como Funciona o RLHF na Prática

A técnica combina três elementos fundamentais:

- Modelo de Política: A IA que será treinada

- Modelo de Recompensa: Sistema que avalia o desempenho

- Feedback Humano: Avaliações contínuas de especialistas

O Processo em Etapas

O treinamento ocorre em ciclos iterativos:

1. A IA gera respostas para diferentes problemas

2. Humanos avaliam essas respostas em escalas de qualidade

3. O modelo de recompensa aprende a imitar o julgamento humano

4. A política de aprendizagem é ajustada para maximizar as recompensas

5. O processo se repete continuamente

Aplicações Práticas que Mudam Jogos

Esta abordagem já mostra resultados revolucionários em diversas áreas:

Assistentes Virtuais Mais Úteis

Sistemas de conversação estão sendo treinados para entender nuances culturais e contextos sociais específicos, tornando as interações mais naturais e menos propensas a erros constrangedores.

Medicina de Precisão

Na área da saúde, algoritmos estão aprendendo a considerar não apenas dados clínicos, mas também aspectos éticos e preferências dos pacientes, graças ao feedback constante de profissionais médicos.

Desafios e Considerações Éticas

Apesar dos avanços, a técnica apresenta questões importantes:

- Como garantir a diversidade nos avaliadores humanos?

- Riscos de incorporar vieses conscientes ou inconscientes

- Custos operacionais do treinamento contínuo

- Desafios de escalabilidade para sistemas complexos

O Debate sobre Supervisão Humana

Pesquisadores alertam que o método não é uma solução mágica: 'O feedback humano precisa ser constantemente calibrado e validado para evitar que a IA aprenda preferências individuais em vez de valores coletivos', destaca o estudo.

O Futuro do Treinamento de IA

As perspectivas para essa tecnologia são amplas:

Educação Adaptativa: Sistemas que aprendem em tempo real com o feedback de professores e alunos para personalizar o processo de aprendizagem.

Robótica Colaborativa: Máquinas industriais que ajustam seu comportamento conforme a avaliação contínua dos operadores humanos.

Integração com Outras Tecnologias

A combinação do RLHF com outras inovações como redes neurais transformers e sistemas multimodais promete criar uma nova geração de IAs capazes de entender não apenas o que fazemos, mas por que fazemos.

Implicações para o Mercado Brasileiro

No contexto nacional, essa tecnologia apresenta oportunidades únicas:

- Desenvolvimento de assistentes virtuais em português com compreensão regional

- Sistemas de atendimento ao cliente adaptados à cultura local

- Ferramentas governamentais com maior transparência e controle humano

Preparação para a Era da IA Regulada

Com a discussão sobre leis de IA ganhando força, o RLHF se posiciona como alternativa técnica para atender futuras exigências de transparência e controle humano sobre sistemas autônomos.

Conclusão: O Papel Central da Humanidade

O aprendizado por reforço com feedback humano representa mais que um avanço técnico - simboliza uma reafirmação do papel central das pessoas no desenvolvimento tecnológico. Ao criar sistemas que aprendem não apenas com dados, mas com valores humanos, damos um passo crucial rumo a uma inteligência artificial verdadeiramente benéfica e alinhada com nossas necessidades sociais e éticas.

Os desafios técnicos e filosóficos permanecem, mas a direção está clara: o futuro da inteligência artificial será construído através de colaboração contínua entre humanos e máquinas, não por sua substituição.