A Era dos Processadores de Uso Geral chega ao Fim: Entendendo o Futuro da Inteligência Artificial

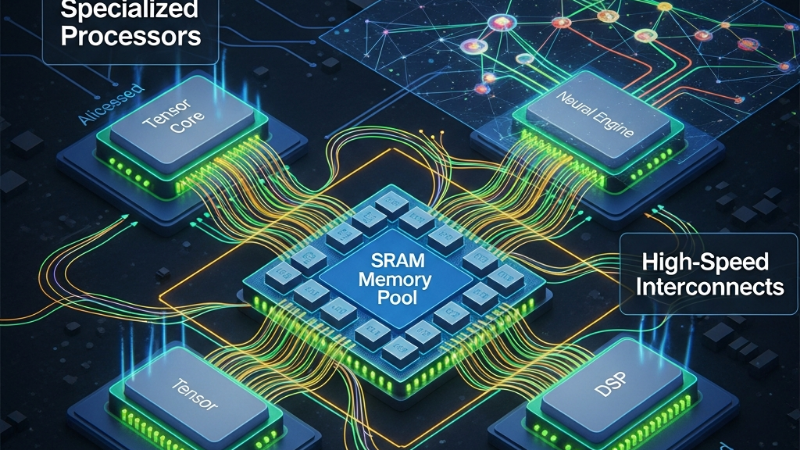

A indústria de tecnologia está se movendo em direção a uma arquitetura de inferência desagregada, onde os processadores são especializados em realizar tarefas específicas. Isso permitirá que as empresas desenvolvam modelos de IA mais eficientes e escaláveis.

Introdução

A era dos processadores de uso geral parece estar chegando ao fim. Recentemente, foi anunciado que a indústria de tecnologia está se movendo em direção a uma arquitetura de inferência desagregada, onde o silício é dividido em dois tipos diferentes para acomodar um mundo que exige tanto contexto massivo quanto raciocínio instantâneo.

O que é a Arquitetura de Inferência Desagregada?

A arquitetura de inferência desagregada é uma abordagem que divide as cargas de trabalho de inferência em duas fases principais: preenchimento e decodificação. O preenchimento é a fase em que o modelo deve ingerir grandes quantidades de dados e computar uma compreensão contextual, enquanto a decodificação é a fase em que o modelo gera tokens um a um, alimentando cada um de volta no sistema para prever o próximo.

Por que a Arquitetura de GPU não é mais suficiente

A arquitetura de GPU tradicional não é mais suficiente para atender às demandas de inferência de IA. A GPU é excelente em realizar multiplicações de matrizes, mas não é eficiente em lidar com a memória e a largura de banda necessárias para a decodificação. Além disso, a GPU é cara e limitada em termos de capacidade, o que torna difícil escalá-la para atender às necessidades de inferência de IA.

A Importância da Memória

A memória é um componente crítico na arquitetura de inferência de IA. A memória SRAM (Static Random Access Memory) é particularmente importante, pois é capaz de armazenar e recuperar dados rapidamente. No entanto, a memória SRAM é cara e limitada em termos de capacidade, o que torna necessário encontrar soluções alternativas.

O Futuro da Inteligência Artificial

O futuro da inteligência artificial parece estar se movendo em direção a uma arquitetura de inferência desagregada, onde os processadores são especializados em realizar tarefas específicas. Isso permitirá que as empresas desenvolvam modelos de IA mais eficientes e escaláveis, capazes de atender às necessidades de inferência de IA em tempo real.

Conclusão

A era dos processadores de uso geral está chegando ao fim, e a indústria de tecnologia está se movendo em direção a uma arquitetura de inferência desagregada. A memória SRAM é um componente crítico nessa arquitetura, e as empresas precisam encontrar soluções alternativas para atender às necessidades de inferência de IA. O futuro da inteligência artificial é promissor, e as empresas que investirem em arquiteturas de inferência desagregada estarão melhor posicionadas para aproveitar as oportunidades que surgirão.